本次ICLR2022我们共中稿三篇文章,其中两篇会在周二宣讲,一篇在周四宣讲。欢迎大家过来询问。

Understanding Dimensional Collapse in Contrastive Self-supervised Learning

(文章链接Understanding Dimensional Collapse in Contrastive Self-supervised…,Poster Session 5,加州时间4月26日周二上午10点30分,北京时间4月27日周三凌晨1点30分)

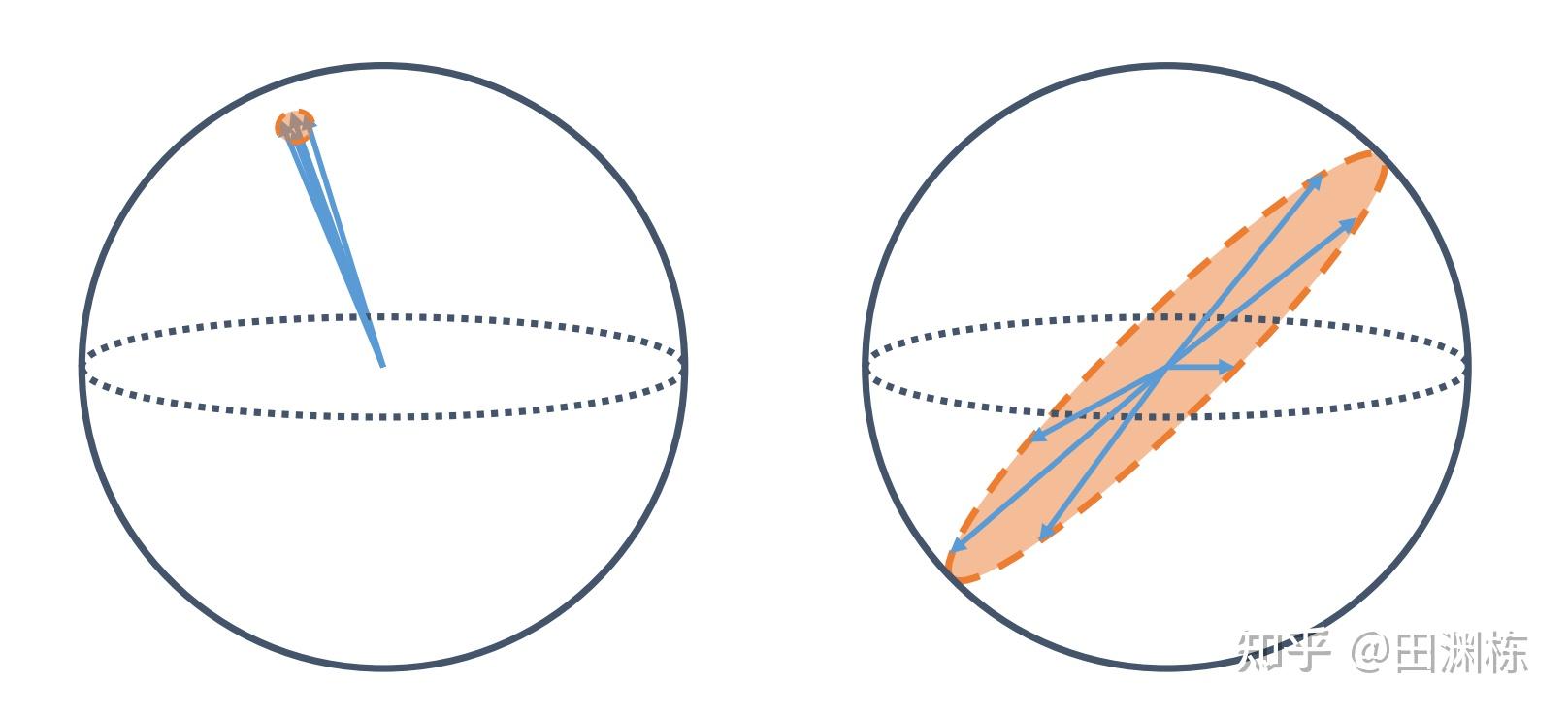

这篇讲的是对比学习(contrastive learning)学习中的向量塌缩问题。从目标函数的设计角度看,对比学习应当能充分挖掘学得的嵌入向量(embedding vector)的每个维度,让每个维度都能携带有用信息;但实际情况并非如此:对比学习仍然会受困于维度塌缩(dimensional collapsing):在训练完之后,嵌入向量的某些分量确实携带了信息,而其它的一些分量自始至终非常小。这个问题可能会导致对比学习没有办法充分利用嵌入向量的维数。

这篇文章分析了这个问题,在线性的情况下,从理论上证明有两个因素导致了对比学习的维度塌缩。首先,在过强的数据增强 (strong augmentation)的情况下,可以证明如果网络是单层线性,那么在InfoNCE的梯度动力学的驱动下,其权重会收敛到一个低秩解,自然导致纬度塌缩。其次,在两层线性时,相邻变量矩阵的奇异值会逐渐耦合在一起,使得小的奇异值变得相对更小,权重矩阵趋向于低秩。

那么这些分析在实际应用中有何价值呢?在实际应用中,对比学习需要加一个额外的投影层(projector)来防止嵌入向量的维度塌缩。根据这个理论,因为奇异值空间会自动耦合,这个投影层里的很多参数都是不必要的,所以我们提出一种简便方法DirectCLR,把投影层去掉,而直接把嵌入向量的子向量接入InfoNCE的目标函数,这样可以同时满足“空间耦合”及“低秩”的条件,训练效果也与加了线性投影层的基线方法相当。

本文还有一篇英文博客,感兴趣的话可以点这里:https://ai.facebook.com/blog/understanding-dimensional-collapse/

基于这篇ICLR的理论分析,我有一篇拓展工作(见Deep Contrastive Learning is Provably (almost) Principal Component Analysis),证明对比学习的一类目标函数,包括InfoNCE,其实是对应于一个maxmin优化,就相当于有两个玩家在对弈,玩家A想要学到更好的表示,玩家B则想尽办法找到这个表示的弱点,即“不同的样本其表示却非常接近”这样的情况。这样就拓展了对比学习目标函数的设计空间。基于这个结论,在网络是多层线性的情况下,还可以进一步证明,如果玩家B不参与的话,玩家A学到的是主成分分析(PCA)的表示,这样就把PCA和对比学习联系了起来。之后我会再写一篇专栏,做更详细的解说。